Qué significa realmente una IA responsable

La IA responsable no se limita a optimizar modelos o reducir costes de infraestructura. Se trata de construir una adopción de la inteligencia artificial que perdure en el tiempo. Implica diseñar sistemas de IA integrados en las operaciones diarias, asumidos por los equipos y capaces de escalar junto con la organización.

En términos prácticos, una IA responsable es una IA capaz de resistir la complejidad del mundo real.

Las investigaciones globales de McKinsey sobre adopción de IA muestran que, aunque la mayoría de las empresas afirma utilizar IA en al menos una función, muchas menos consiguen un impacto significativo a nivel corporativo. La brecha no se debe a algoritmos débiles, sino a la dificultad de integrar la IA en los flujos de trabajo y en los procesos de toma de decisiones.

En su informe Superagency in the Workplace, McKinsey destaca además que la IA genera valor medible cuando mejora la forma en que las personas trabajan, y no cuando se implementa como una capa tecnológica desconectada.

Por tanto, la IA responsable es inseparable de una IA sostenible, es decir, de una adopción sólida y continua.

Por qué la adopción de la IA fracasa tras la fase piloto

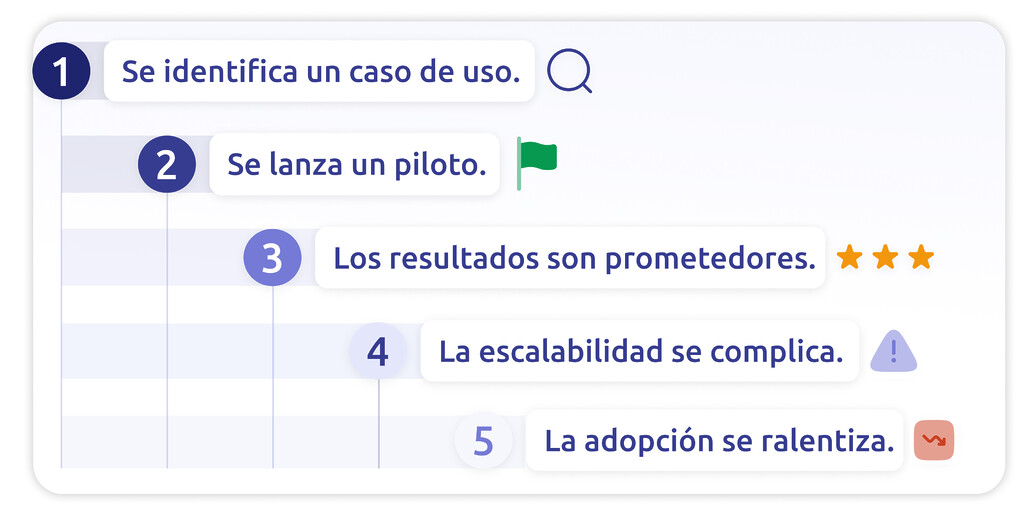

El ciclo de las iniciativas de IA que no prosperan suele repetirse. Se identifica un caso de uso atractivo. Se lanza un piloto. Los primeros resultados son positivos. Se inicia la fase de escalado. Aparece la resistencia. Aumenta la complejidad. La adopción se ralentiza. Finalmente, el proyecto pierde relevancia.

El problema rara vez es técnico. Es, sobre todo, organizativo.

Con demasiada frecuencia, la IA se superpone a los sistemas existentes en lugar de integrarse en ellos. Los equipos deben consultar nuevos paneles, utilizar interfaces adicionales o adaptarse a procesos paralelos. En lugar de simplificar el trabajo, la IA lo complica. Cuando aumenta la fricción, disminuye la confianza. Y cuando disminuye la confianza, la adopción se desploma.

Boston Consulting Group confirma que, aunque la mayoría de las organizaciones está experimentando con IA, solo una minoría logra escalar el valor a nivel empresarial. Los factores limitantes son la gobernanza, el rediseño del modelo operativo y la gestión del cambio, más que la sofisticación de los modelos.

En su estudio Are You Generating Value from AI? The Widening Gap, BCG explica que las empresas que generan impacto tratan la IA como una transformación organizativa y no como un simple despliegue tecnológico.

La IA responsable comienza donde termina la cultura del piloto.

La base humana de la IA responsable

En los contact centers, la adopción de la IA depende de las personas que la utilizan cada día. Agentes, supervisores y responsables operativos deciden en la práctica si la IA se convierte en un asistente de confianza o en una funcionalidad ignorada.

Si los equipos de primera línea no entienden cómo la IA respalda sus objetivos, volverán a sus hábitos habituales. Si la IA altera los flujos de trabajo sin aportar beneficios claros, surgirá la resistencia. Por eso, la adopción de la IA por parte de la plantilla debe considerarse una prioridad estratégica y no un elemento secundario.

Una IA responsable es profundamente humana. Requiere transparencia, formación y claridad sobre cómo la IA mejora el rendimiento sin amenazar los roles. Las investigaciones sobre barreras en la adopción de la IA señalan de forma constante que la falta de gobernanza clara, el bajo compromiso de los usuarios y la resistencia organizativa frenan más los proyectos que las limitaciones técnicas.

La adopción no es automática. Se construye.

El papel de los “Glue Employees” en la gestión del cambio

En toda iniciativa de IA responsable que tiene éxito, existen personas que actúan como puente entre la innovación y la operación. Puede que no ocupen cargos directivos, pero desempeñan un papel decisivo en la gestión del cambio.

Son los llamados “Glue Employees”.

Estos profesionales traducen la estrategia en práctica. Prueban nuevas funcionalidades, comparten feedback, tranquilizan a los compañeros escépticos y demuestran el valor en las tareas diarias. Generan credibilidad en torno a la IA porque cuentan con la confianza de sus colegas.

Sin estos perfiles, la IA sigue siendo una iniciativa impulsada por la dirección. Con ellos, se convierte en parte de la realidad operativa del equipo.

La IA responsable depende de estos embajadores internos. La tecnología escala más rápido cuando la convicción se extiende de forma natural.

En los contact centers, la IA debe integrarse, no añadirse

Una de las principales causas de una adopción limitada de la IA en los contact centers es la mala integración. Cuando las herramientas de IA obligan a los agentes a cambiar de plataforma, duplicar la introducción de datos o interpretar sugerencias sin contexto, la eficiencia disminuye en lugar de mejorar.

Una IA responsable en los contact centers implica que la inteligencia artificial forme parte del ecosistema existente. Las sugerencias en tiempo real aparecen directamente en la interfaz del agente. Los resúmenes automáticos reducen el trabajo posterior a la llamada sin añadir pasos adicionales. Los insights de calidad se integran en los flujos de supervisión y no se entregan mediante herramientas de reporting aisladas.

El objetivo es claro: reducir la carga cognitiva.

Los estudios de campo sobre IA generativa en entornos profesionales muestran que los incrementos de productividad se producen cuando la IA está integrada en los flujos de trabajo y no cuando funciona como una aplicación independiente.

Si la IA no se alinea con la forma en que las personas ya trabajan, su adopción será limitada. Una IA sostenible exige coherencia.

La IA responsable requiere un ecosistema tecnológico coherente

Además del factor humano, la IA responsable depende de una arquitectura técnica sólida. Muchas organizaciones acumulan soluciones de IA desconectadas con el tiempo, generando flujos de datos fragmentados y sistemas redundantes. Este enfoque incrementa la complejidad y dificulta la escalabilidad.

Una IA responsable requiere un ecosistema unificado en el que modelos, datos y flujos de trabajo operen de forma coherente. Exige una infraestructura capaz de evolucionar con el crecimiento del negocio y soluciones diseñadas para funcionar conjuntamente.

El informe Closing the AI Impact Gap de BCG subraya que las empresas que generan valor medible a partir de la IA la abordan como una decisión de plataforma y no como una colección de experimentos.

En los contact centers, esto implica que la telefonía, el CRM, la analítica y las capacidades de IA funcionen en un entorno consistente. La escalabilidad depende de esa coherencia.

Los bucles de feedback impulsan la adopción a largo plazo

La IA responsable no es estática. Evoluciona mediante iteración.

Los sistemas de IA que incorporan feedback estructurado de agentes y supervisores se vuelven más precisos, más relevantes y más fiables. La monitorización continua, el ajuste de modelos y la alineación con los KPI operativos transforman la IA en una capacidad dinámica.

Sin bucles de retroalimentación, la IA se estanca. Sin evolución, la confianza se erosiona. Una IA sostenible requiere sistemas diseñados para aprender del uso real y adaptarse en consecuencia.

La confianza es el verdadero fundamento de la IA responsable.

La IA responsable como ventaja estratégica en los contact centers

Los contact centers son uno de los entornos operativos más humanos dentro de cualquier organización. El rendimiento depende de la empatía, la capacidad de respuesta y la coherencia. La IA puede reforzar estas capacidades, pero solo si se adopta a escala.

Una IA responsable en los contact centers potencia a los agentes en lugar de sustituirlos. Mejora el rendimiento sin aumentar la complejidad. Apoya los objetivos operativos respetando la experiencia humana.

El éxito a largo plazo no depende de desplegar el modelo de IA más avanzado, sino de lograr una adopción profunda y sostenida por parte de la organización.

De la experimentación a la IA responsable

La IA responsable no consiste en lanzar más pilotos. Consiste en diseñar estrategias de adopción que perduren.

Requiere alineación del liderazgo, comunicación clara, una gestión del cambio sólida, Glue Employees que impulsen la confianza, flujos de trabajo integrados, tecnología escalable y feedback continuo.

Cuando estos elementos convergen, la IA deja de ser una iniciativa puntual y pasa a formar parte del modo en que opera la organización.

Eso es la IA responsable.

¿Listo para construir una IA responsable?

La IA responsable no trata de lanzar pilotos.

Trata de construir una adopción que perdure.

Si quiere entender cómo pasar de la experimentación a una IA en contact centers verdaderamente escalable y cómo impulsar la adopción real por parte de los equipos, descargue nuestro ebook:

Descubra como adoptar una IA responsable